Introdução à Análise de Dados

A análise de dados se mostra como algo fundamental em qualquer organização independentemente do seu porte.

A razão para isso é muito simples: a quantidade de informações que são geradas em um curto espaço de tempo é enorme devido ao aumento de acesso às métricas e dados.

Essas informações são essenciais, pois ajudam as empresas a se manterem competitivas, aliás, este é um desejo de todas elas.

Por esse motivo, realizar a coleta de informações é tão fundamental, pois vai ajudar a criar um plano de ação que ajudará a se destacar e ter mais lucros.

Mas se tiver acesso a todo tipo de dados e não souber interpretá-los corretamente de nada vai adiantar. Para isso, são utilizadas algumas ferramentas para análise de dados.

Algumas das ferramentas que podem ser usadas são:

- Diagrama de Ishikawa,

- Gráfico de Pareto,

- Folha de Verificação

- Gráfico de Dispersão

Que tal conhecermos um pouco mais sobre a importância da análise de dados e outros pontos tão importantes nesse sentido?

Tabela de Conteúdo

- O que é análise de dados?

- Como a análise funciona na prática?

- Princípios da análise de dados

- Ferramentas para a análise de dados

- Conclusão da Análise de Dados

O que é análise de dados?

Quando falamos em um ambiente organizacional nos deparamos com uma porção de dados, mas eles precisam deixar de ser números para se transformarem em informações.

Essa transformação vai ajudar a perceber o tipo de problema observado e a frequência do problema. A partir desse entendimento as soluções para tais problemas surgem.

Entretanto, fazer essa transformação não é algo simples de ser feito e é necessário conhecer as metodologias de análise para uma correta avaliação dos dados.

Há inúmeras ferramentas para análise de dados. Elas são muito poderosas na investigação do que causa dos defeitos e se dividem em duas categorias principais que são:

- Análise de dados – os dados que são coletados são utilizados para encontrar as tendências, os padrões e demais diferenças que possam suportar, sugerir ou rejeitar as teorias sobre as causas ou defeitos.

- Análise dos processos – os processos chave existentes são visualizados mais detalhadamente com o intuito de identificar o tempo de retrabalho, ciclo, quebra e demais passos que acabam não agregando valor ao cliente.

Quer ser um especialista em análise de dados? Confira nosso curso Green Belt EAD!

É importante fazer a análise dos dados?

As empresas precisam tomar decisões a todo momento e muitas delas são de fundamental importância, pois podem determinar o futuro delas.

A tomada de decisão não se trata de sorte, mas de análise dos dados que aquela empresa possui.

Conseguir prever, mesmo que de forma parcial, algo como, por exemplo, o comportamento do mercado daqui há certo tempo, é de grande importância, pois permite se organizar para isso.

Assim, quando acontecer, a empresa já estará preparada e poderá usufruir de todos os benefícios disso. Basicamente, a análise de dados pode ser feita através de quatro tipos distintos. São eles:

Análise preditiva

Entre os tipos de análise de dados existentes certamente a análise preditiva é a mais conhecida e utilizada.

Através dela é possível prever como o mercado vai se comportar, quais os padrões de consumo entre outras informações.

A análise estatística é utilizada em conjunto com inteligência artificial e dados históricos para conseguir ter uma boa predição. Até mesmo os riscos e as oportunidades que podem ocorrer em um futuro próximo podem ser indicados por essa análise.

Essa análise tem como objetivo principal entender melhor o fenômeno ocorrido para a partir daí fazer uma previsão mais certeira sobre os possíveis resultados futuros.

Análise prescritiva

Na vida, sempre precisamos tomar uma decisão e ela trará uma consequência. O intuito da análise prescritiva é determinar o que pode ocorrer após certa atitude ser tomada. Para isso, ela necessita do elemento humano.

Como a função dessa análise é apontar qual o caminho que deve ser percorrido para que tudo ocorra conforme o planejado, ela é a mais complexa dentre os quatro tipos.

Afinal, não basta que o profissional domine as técnicas do data science, mas que entenda muito bem o negócio em questão.

Análise descritiva

O intuito da análise descritiva é saber o quão arriscado é determinada ação. Como se trata de uma análise de risco, os bancos costumam utilizar esse processo na análise de crédito para definir as taxas de juros.

A análise descritiva é indicada quando se deseja entender o impacto que certa decisão no presente tem utilizado a visualização de dados.

Entretanto, para que isso ocorra, não é feito um julgamento de valor. Isso faz com que as decisões imediatas sejam tomadas com mais tranquilidade e segurança.

Análise diagnóstica

O objetivo da análise diagnóstica é indicar tanto o impacto quanto o alcance que certa tomada de decisão causará. Isso possibilita que as estratégias sejam aperfeiçoadas, o que faz com que a empresa agregue mais valor.

O destaque de sua aplicação são as vendas e, em conjunto com a análise preditiva, impacta grandemente os lucros da empresa.

Como a análise funciona na prática?

Grande parte das equipes Lean Six Sigma fazem uso tanto da análise de dados quanto a de processos em seus projetos.

No início, utiliza-se a análise de dados, mas nada impede que a análise de processo seja utilizada antes ou que parte da equipe utilize essas análises simultaneamente.

Independentemente de qual conjunto a equipe Lean Six Sigma faça uso, ela terá de passar pelas três fases que a análise da causa raiz apresenta:

- Exploração – processo e dados são investigados sem qualquer tipo de tendência, pois o intuito é ver o quanto que se aprende;

- Geração de hipóteses relacionadas às causas – o novo conhecimento é utilizado com o intuito de identificar quais são as causas mais prováveis para aqueles defeitos;

- Hipóteses são testadas ou as causas eliminadas – os dados e experimentos são utilizados ou o processo passa por mais análise para que as potenciais causas que acabam contribuindo para o problema sejam verificadas.

A mente deve estar limpa no estágio de exploração, pois pode acontecer da equipe já possuir alguma teoria antes de iniciar o trabalho e acabar eliminando causas que possuem tudo a ver com o problema.

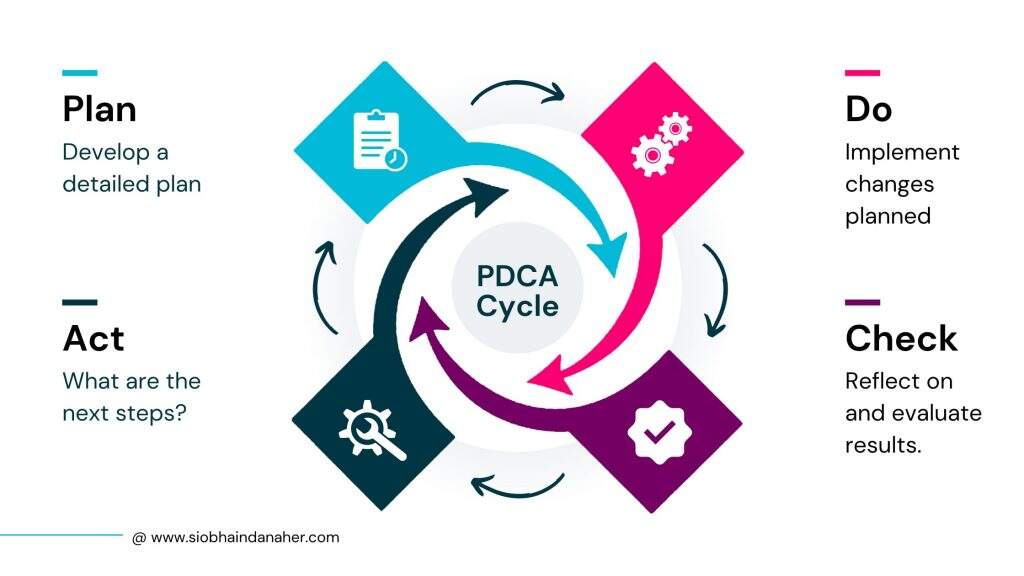

Grande parte das equipes Lean Six Sigma participam de vários PDCA’s antes que as causas para certos problemas sejam eliminadas. Assim, esses estágios podem ser realizados na sequência ou fora dela, podem até ser revisitados posteriormente.

O que importa é que o propósito do projeto esteja claro para que a equipe seja mantida focada nas reuniões.

Princípios da análise de dados

O primeiro ponto a ser feito é definir qual o foco que a análise de dados terá. É preciso que esteja bem claro o que é preciso descobrir ou qual o problema que necessita de uma solução.

Isso é fundamental, pois com tanta informação é fácil acabar perdendo o foco. É uma ótima ideia sempre revisitar o objetivo dessa análise e o problema.

Para ajudar a manter o foco existem ferramentas muito interessantes, mas as mais importantes certamente são o Ciclo PDCA e as Três Questões Fundamentais. Com relação às Três Questões Fundamentais, ela contém três questões que são:

- O que se quer realizar?

- Como saber que o objetivo desejado foi atingido?

- O que é preciso fazer para que o objetivo seja atingido?

Por exemplo, você está trabalhando em um projeto cujo intuito é promover uma melhora na qualidade de certa linha de produção.

Primeiramente, é preciso entender o que é a qualidade para ela para, assim, ter um indicador que ajuda a responder a segunda pergunta.

Talvez seja possível dizer que após o número de defeitos ter sofrido uma redução a qualidade obteve uma melhora. Assim:

- O que se quer realizar: promover uma melhora na qualidade da linha

- Como saber que o objetivo desejado foi atingido: quando houver uma redução no indicador de defeitos da linha

- O que é preciso fazer para que o objetivo seja atingido: pode-se utilizar uma ferramenta que ajude a entender a ocorrência de certo defeito como o Diagrama de Ishikawa.

Definição das hipóteses

Quando se faz a análise de dados é fundamental ter uma hipótese que explique o que está acontecendo. As hipóteses são de grande importância, pois com elas é possível entender o fenômeno que está acontecendo.

Além do mais, é possível dar uma refinada nela para que uma teoria de maior complexidade seja elaborada e que ajude a prever como o processo ou fenômeno estudado irá se comportar.

Nos ambientes corporativos a criação de hipótese leva em consideração as oportunidades ou os problemas. Por exemplo, há 3 meses um restaurante vem tendo uma queda em seu faturamento e o movimento está ficando cada vez mais fraco.

Este seria o problema que foi percebido. Uma hipótese para que isso esteja acontecendo é que a equipe de garçons é nova e inexperiente.

Essa hipótese precisa ser testada a fim de verificar se ela é ou não verdadeira. A análise serve para isso.

Assim, é preciso dividir os dados das reclamações dos clientes entre clientes que os novos garçons serviram e clientes atendidos por garçons experientes.

A partir daí é necessário procurar as diferenças que existem nesses grupos. Mas atenção, é preciso entender que a hipótese pode estar errada e que a causa para tanta reclamação e baixa no faturamento ser outra. Os dados que vão contra a hipótese não podem ser ignorados.

Como as perguntas devem ser estruturadas ?

Quando se quer desvendar algo é preciso fazer diversas perguntas com relação ao impacto, frequência e tipo de sintomas.

O ideal é que sejam feitas várias questões relacionadas aos dados e, através das análises, encontrar as que possuem maior importância.

Assim, segundo o nosso exemplo do restaurante, é preciso entender a frequência com que ocorre a reclamação de quem foi atendido pelos garçons mais jovens.

Também é preciso entender qual o tipo de problema que está sendo observado, ou seja, o que os clientes reclamam.

Por fim, qual o impacto que o problema promove, isto é, qual a chance daqueles clientes retornarem ao restaurante, maior ou menor?

É preciso que a equipe entenda bem os problemas para que as escolhas corretas quanto ao investimento de tempo e onde a implementação das mudanças devem ocorrer sejam feitas.

Ferramentas para a análise de dados

A análise de dados pode ser feita utilizando-se ferramentas próprias que se dividem em baixa, média e alta complexidade.

Baixa complexidade

As ferramentas de baixa complexidade são:

- Diagrama de Ishikawa – Permite realizar discussões com relação às possíveis causas para um determinado efeito.

- Gráfico de tendência – Permite analisar as causas especiais com o intuito de entender quando um processo ocorre ou não dentro do padrão.

- Gráfico de Pareto – Pertencente às 7 ferramentas da qualidade, essa ferramenta é utilizada para priorizar as ações de melhorias ou análises dos dados.

- Formulário de Coleta de Dados – Deve ser usado sempre que for necessário coletar novos dados com o intuito de testar uma hipótese.

- Folha de verificação – Pertencente as Sete Ferramentas da Qualidade, este é um formulário especial para a coleta de dados que permite que essa coleta seja mais fácil e que esteja atrelada a uma característica em especial do produto.

- 5 porquês – Utilizada para entender quais as causas mais profundas de certo problema.

- Gráfico de dispersão – Também pertencente às 7 ferramentas da qualidade, esse gráfico procura correlações entre as variáveis e estudar as hipóteses influenciadoras.

- Histograma – Permite entender a frequência de valores existente na distribuição de dados. Utilizada para estudar o comportamento natural do processo.

- Box-Plot – Também utilizado para avaliar a frequência dos dados. Permite uma comparação mais fácil das distribuições, dos vários cenários ou dos tratamentos.

Média complexidade

As principais ferramentas de média complexidade são:

- Regressão Linear – Permite dizer quanto que uma variável consegue influenciar outra.

- Cartas de Controle – Esta ferramenta da qualidade permite fazer o limite de controle para que a variação do indicador seja acompanhada ao longo do tempo.

- Análises de Capabilidade – Permite dizer se a variação que ocorre em um processo está dentro daquilo que o cliente espera.

- Análise do Sistema de Medição (MSA) – Permite entender o quanto a falta de eficiência na coleta de dados está comprometendo a análise.

- FMEA – A Análise do Modo de Falha ajuda no melhor entendimento do que pode causar certa falha no processo ou produto.

Alta complexidade

Nas ferramentas de análise de dados de alta complexidade temos:

- Análises de probabilidade – Os dados precisam ser analisados e isso ajuda a entender as hipóteses de maior complexidade. A probabilidade mostra o quanto que algo tem chance de acontecer e uma das formas de chegar a esse resultado é através do Teorema de Bayes.

- ANOVA – Essa análise procura as diferenças existentes entre grupos de dados por meio da variação apresentada pelos dados.

- Design de Experimentos (DOE) – O intuito é fazer com que se tenha custo mínimo, mas o máximo de informação possível.

Conclusão da Análise de Dados

Depois de tudo o que aprendemos sobre análise de dados, sua importância é essencial, mais evidente do que nunca.

Embora ainda estejamos percorrendo o Big Data, os resultados não podem ser ignorados.

A ciência de dados continuará a crescer e evoluir e só podemos adivinhar a que revelações isso levará!